Risoluzione ottica dello scanner

Nel mondo moderno, la parte principale degli sviluppi è occupata dalle tecnologie informatiche. Sono entrati nelle nostre vite e hanno trovato applicazione in quasi tutte le aree dell'attività umana. Tutte le apparecchiature sono suddivise in dispositivi per l'input e l'output di informazioni, nonché in un processore centrale.

Nel mondo moderno, la parte principale degli sviluppi è occupata dalle tecnologie informatiche. Sono entrati nelle nostre vite e hanno trovato applicazione in quasi tutte le aree dell'attività umana. Tutte le apparecchiature sono suddivise in dispositivi per l'input e l'output di informazioni, nonché in un processore centrale.

Quando lavorano in modo interconnesso, sono in grado di eseguire rapidamente varie attività. Per navigare in un'ampia varietà di tecnologie, è necessario conoscere le caratteristiche tecniche e le caratteristiche operative. Questo ti aiuterà a confrontare diversi modelli per scegliere quello migliore.

Uno dei dispositivi per l'immissione di informazioni in un database informatico sono gli scanner. Permettono lo scaricamento dei dati in formato grafico da un supporto stampato. A seconda delle caratteristiche tecniche, dei materiali utilizzati e della qualità costruttiva, la qualità risultante sarà diversa per le diverse versioni dell'apparecchiatura. Questo dovrebbe essere preso in considerazione quando si sceglie e si acquista uno scanner.

Il contenuto dell'articolo

Cos'è la risoluzione ottica?

Esistono molti parametri che svolgono un ruolo importante nel garantire un trasferimento di dati di alta qualità in formato elettronico. Uno dei criteri di selezione più significativi è la risoluzione ottica. Prima di confrontare i modelli basati su questo indicatore, è necessario conoscerne lo scopo principale. La definizione del concetto ti aiuterà a capirlo.

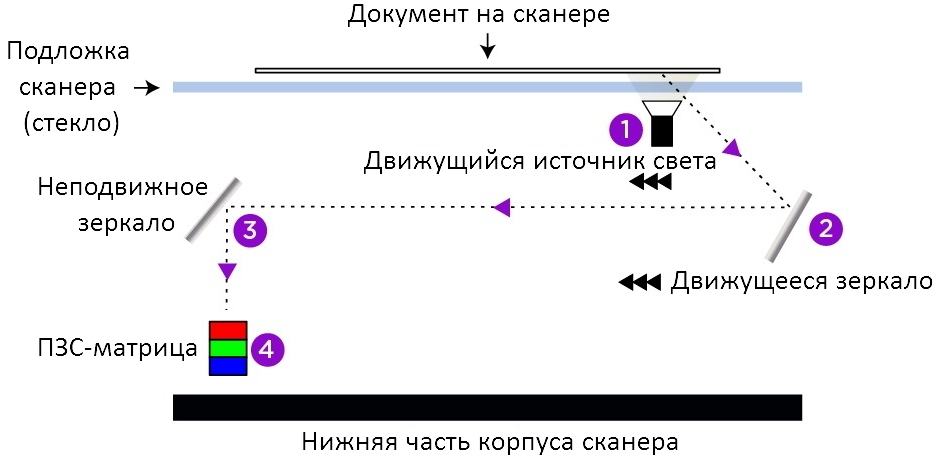

La risoluzione ottica è uno dei criteri più indicativi utilizzati per valutare la qualità di uno scanner. Questo parametro mostra il numero di punti riconosciuti di un'intera area dell'immagine. Questo indicatore indica il numero massimo consentito di punti che un dispositivo di scansione può riconoscere dall'area di una pagina stampata.

La risoluzione ottica è uno dei criteri più indicativi utilizzati per valutare la qualità di uno scanner. Questo parametro mostra il numero di punti riconosciuti di un'intera area dell'immagine. Questo indicatore indica il numero massimo consentito di punti che un dispositivo di scansione può riconoscere dall'area di una pagina stampata.

Tutti i file elettronici e i documenti stampati sono costituiti da tanti piccoli punti (pixel), il loro numero determina l'uniformità della distribuzione del colore sulla superficie dello schermo o del foglio di carta, a seconda del tipo di presentazione dei dati. Ogni pixel porta la codifica con informazioni su un colore o la sua sfumatura. Pertanto, maggiore è il numero di pixel utilizzati per la codifica situati sul foglio, più luminosa e satura risulterà la visualizzazione del documento o della fotografia.

Importante! Oltre alla luminosità e alla saturazione, la risoluzione ottica influisce sulla chiarezza del display.

Un gran numero di punti attenua i bordi, creando un'immagine chiara. Se sono presenti pochi punti, l'immagine sarà composta da quadrati con bordi irregolari, il che ne ridurrà notevolmente la qualità.

In quali unità si misura?

Per comprendere il principio base della valutazione, vale la pena studiare le unità di misura destinate a determinarne il valore. Nella descrizione classica si distinguono due tipi di grandezza misurata:

Per comprendere il principio base della valutazione, vale la pena studiare le unità di misura destinate a determinarne il valore. Nella descrizione classica si distinguono due tipi di grandezza misurata:

- Le unità di misura più familiari agli utenti sono dpi (punti per pollice), è questo parametro che gli sviluppatori indicano sul corpo della loro attrezzatura e nel manuale di istruzioni. Visualizza il numero di punti posizionati su una striscia da un pollice.L'indicatore è simile a quello delle stampanti, solo che in questo caso permette di valutare la capacità di lettura dello scanner (mostra quanti pixel il dispositivo può convertire in formato elettronico per l'inserimento in un database informatico). Solitamente indicato nel formato: 300×300, 600×600…

- Un'altra opzione di misurazione è spi (campioni per pollice): questo è il numero di campioni che uno scanner può creare quando lavora con una pagina stampata. In questo caso, vengono fornite informazioni su quante volte il tecnico visualizza l'immagine situata a un pollice. Ad esempio, se su un pollice sono presenti 300 sensori di lettura, la risoluzione sarà di 300 spi. Questo criterio è più informativo.

Importante! Quando si sceglie uno scanner con una designazione di risoluzione in formato dpi, è necessario prestare attenzione al primo numero, è questo che indica la capacità di scansionare i dati.

Questo concetto è un termine generale per la risoluzione ottica e di interpolazione. Insieme, mostrano il numero massimo consentito di punti che il dispositivo può riconoscere e codificare per il trasferimento alla matrice. Più alti sono questi indicatori, migliore sarà la formazione dell'immagine finale.

Inoltre, da questo parametro dipende la possibilità di ridimensionare l'immagine risultante sullo schermo del monitor senza modificarne la qualità, pur mantenendo la chiarezza del contorno e dei confini.